L’essentiel à retenir : l’étude de Cao et Chen (décembre 2025) démontre que l’IA déduit désormais des secrets industriels majeurs à partir de simples communications publiques anodines. Cette capacité d’inférence rend les stratégies classiques de confidentialité obsolètes, imposant une gouvernance stricte où chaque mot publié devient une vulnérabilité potentielle nécessitant une supervision humaine constante pour éviter l’hémorragie informationnelle.

L’époque où la confidentialité se limitait aux documents sensibles est révolue : chaque mot publié nourrit désormais une surveillance algorithmique permanente, transformant l’ia communication entreprise en un redoutable vecteur de fuites qui expose vos actifs immatériels. Cette analyse met en lumière la mécanique par laquelle des modèles de langage, agissant tels des analystes insatiables, parviennent à exfiltrer vos secrets les mieux gardés par simple inférence croisée de données publiques apparemment inoffensives. Face à cette hémorragie informationnelle silencieuse, seules une gouvernance des données radicale et une stratégie de défense proactive permettront d’éviter que votre propre transparence ne finisse par offrir votre avenir sur un plateau à la concurrence.

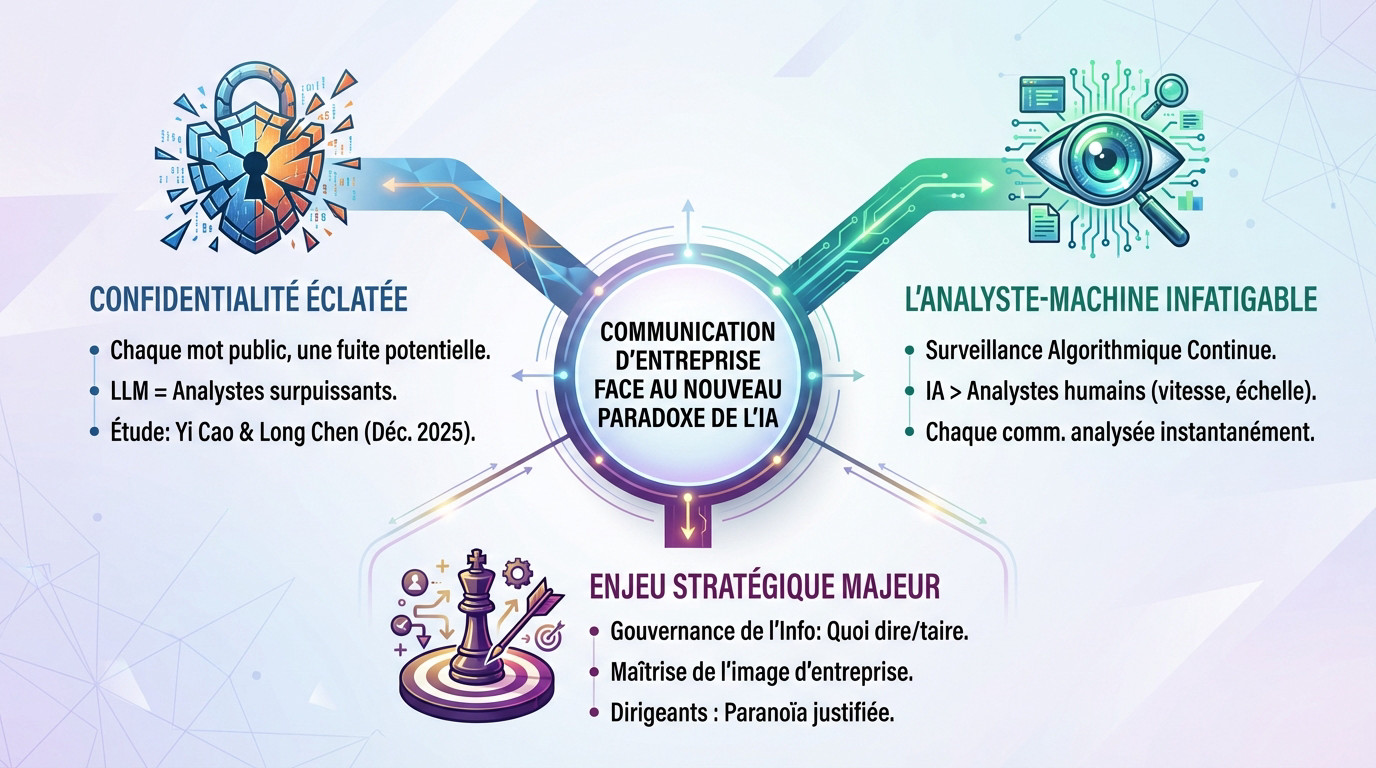

La communication d’entreprise face à un nouveau paradoxe

Vous imaginez sans doute que vos secrets industriels sont bien gardés derrière des pare-feux et des accords de non-divulgation, mais la réalité est bien plus inquiétante. Ce que la majorité des dirigeants ignorent encore, c’est que l’intelligence artificielle a radicalement modifié la définition même de l’information confidentielle, transformant des données publiques banales en armes concurrentielles redoutables. Une étude marquante, publiée le 15 décembre 2025 par Yi Cao et Long Chen, démontre avec une précision glaçante que les règles du jeu ont changé : nous ne sommes plus à l’abri simplement en cachant les chiffres clés.

Le problème ne vient pas d’une faille de sécurité classique, mais de la capacité inédite des algorithmes à reconstituer un puzzle stratégique complet à partir de pièces éparses que personne n’avait jugé utile de protéger. C’est un véritable plantage de couteau dans le dos pour les stratégies de communication traditionnelles, qui se retrouvent obsolètes face à une technologie capable de lire entre les lignes avec une acuité surhumaine. La gravité de la situation impose une révision immédiate de ce que nous considérons comme « public ».

Le périmètre de la confidentialité a volé en éclats

La vision traditionnelle qui consistait à verrouiller uniquement les rapports financiers et les communiqués de presse officiels appartient désormais au passé, balayée par une nouvelle réalité technologique. Aujourd’hui, chaque mot publié, qu’il s’agisse d’une offre d’emploi pour un comptable ou d’un post anodin sur les réseaux sociaux, constitue une fuite potentielle de données critiques. Protéger le secret des affaires est devenu un exercice périlleux, car l’IA exploite la moindre brèche sémantique pour déduire ce que l’entreprise tente désespérément de taire.

Les modèles de langage étendus (LLM) ne se contentent plus de lire passivement les textes ; ils agissent comme des enquêteurs obstinés capables d’inférer des connexions invisibles pour l’œil humain. Une étude récente de décembre 2025 prouve que ces systèmes identifient des stratégies d’innovation ou des cultures d’entreprise toxiques simplement en analysant la syntaxe d’une annonce de recrutement.

Ce constat alarmant émane des travaux de Yi Cao et Long Chen, chercheurs à l’Université George Mason, qui ont mis en évidence cette vulnérabilité structurelle. Leur analyse démontre que la gestion de la divulgation d’informations est devenue un véritable casse-tête pour les dirigeants, car le risque ne réside plus dans le document lui-même, mais dans son interprétation algorithmique.

L’analyste-machine qui ne dort jamais

L’intelligence artificielle possède désormais la capacité d’égaler, et souvent de surpasser, les meilleurs analystes financiers humains en croisant des volumes de données hétérogènes à une vitesse vertigineuse. Là où un expert mettrait des semaines à recouper des indices, l’algorithme reconstitue la stratégie globale d’une firme en quelques secondes, rendant toute tentative de dissimulation partielle totalement inopérante.

Cette surveillance est permanente et algorithmique, car chaque communication émise par l’organisation est instantanément aspirée, digérée et corrélée par des systèmes qui ne connaissent ni la fatigue ni l’oubli. Les journaux de requêtes et la mémoire des modèles conservent des traces indélébiles, transformant chaque interaction numérique en une pièce à conviction potentielle.

Face à cette menace omniprésente, il devient impératif de repenser les méthodes pour améliorer la communication d’entreprise afin de ne laisser aucune prise à ces déductions automatisées. Le contrôle sur le narratif doit être total et sans faille, car l’interprétation des données, elle, échappe désormais complètement aux émetteurs pour tomber entre les mains des machines.

Un enjeu qui dépasse la simple technique

Il serait erroné de croire que ce problème se limite à une question informatique ; il s’agit avant tout d’un défi stratégique majeur touchant à la gouvernance même de l’information au sein des organisations. Les dirigeants doivent désormais arbitrer avec une extrême prudence entre la nécessité de transparence et le risque mortel de fournir involontairement des munitions à leurs rivaux via des canaux supposés sûrs.

La perception de l’entreprise par ses parties prenantes se trouve directement menacée, car une IA peut révéler des incohérences entre le discours officiel et la réalité opérationnelle déduite des données brutes. La maîtrise de l’image ne dépend plus seulement du message envoyé, mais de la capacité à anticiper comment ce message sera décortiqué et reconstruit par des tiers.

L’ère de l’IA impose donc aux décideurs une vigilance confinant à la paranoïa, les obligeant à scruter chaque bribe d’information partagée publiquement comme s’il s’agissait d’un secret d’État. Ce n’est plus de la prudence, c’est une condition de survie dans un environnement où la transparence est devenue un piège.

Quand les données anodines deviennent des fuites stratégiques

Alors voilà le problème : vous pensez verrouiller vos secrets, mais vos miettes d’informations nourrissent l’adversaire.

Les offres d’emploi : des confessions involontaires

Une simple annonce de recrutement ressemble désormais à un aveu complet pour qui sait regarder. L’étude récente de Cao et Chen démontre que les modèles de langage scrutent ces textes pour y déceler des signaux forts, trahissant souvent la stratégie d’innovation.

Si vous cherchez massivement des experts en « machine learning pour la logistique », l’IA ne voit pas une offre d’emploi standard. Elle identifie immédiatement un pivot stratégique majeur, servi sur un plateau d’argent à vos rivaux.

Plus inquiétant, le vocabulaire utilisé pour recruter des comptables peut signaler une culture interne encline à enfreindre les règles. C’est un signal d’alerte pour les investisseurs sophistiqués qui surveillent ces dérapages éthiques.

Ce que vos communications révèlent sans le dire

Cette transparence forcée dépasse largement les ressources humaines dans le domaine de l’ia communication entreprise. Chaque rapport RSE, chaque transcription d’appel de résultats ou post sur les réseaux sociaux constitue une pièce d’un puzzle que vous ne maîtrisez plus.

L’algorithme ignore le bruit pour se focaliser sur le ton et la fréquence des termes. Il connecte des points disparates pour reconstituer un puzzle informationnel que l’œil humain ne verrait jamais.

- Identification des concurrents : L’IA peut cartographier l’écosystème concurrentiel d’une entreprise simplement en analysant ses communications publiques.

- Détection de la culture d’entreprise : Les mots utilisés dans les offres d’emploi ou les rapports annuels trahissent la culture interne (ex: « agressif », « collaboratif », « flexible »).

- Anticipation de la stratégie d’innovation : La demande de compétences très spécifiques dans les recrutements est un indicateur avancé des futurs axes de développement.

Le puzzle de l’intelligence concurrentielle

L’IA ne se contente pas de trouver l’information ; elle la déduit par pure inférence logique. Elle lie une offre d’emploi anodine à un article de blog technique pour révéler un projet confidentiel que vous pensiez caché.

La menace n’est plus une fuite de données massive et unique, mais une hémorragie de micro-informations. Ce flux continu est bien plus insidieux et pratiquement impossible à endiguer avec les méthodes de protection actuelles.

Finalement, chaque collaborateur qui s’exprime publiquement devient involontairement une faille de sécurité. Cela transforme la communication externe en un champ de mines où chaque mot mal pesé peut vous coûter très cher.

Le piège de la communication générée par IA

La dilution des signaux significatifs

Cao et Chen mettent en garde : lorsque l’ia communication entreprise prend la plume, nous courons vers une uniformité inquiétante. Les rapports finissent par tous se ressembler, adoptant un ton lisse et une structure standardisée qui efface toute singularité.

C’est un problème majeur pour les investisseurs sophistiqués. Ils peinent désormais à déceler ces nuances subtiles, ces choix lexicaux spécifiques qui trahissaient autrefois la véritable santé ou l’orientation stratégique d’une société.

Cette homogénéisation vide le discours de sa substance réelle. Un document techniquement irréprochable mais sans aspérité n’offre plus aucune prise à l’analyse critique ; la valeur informationnelle est diluée.

Quand les acteurs opportunistes paraissent crédibles

Si un algorithme peut générer un rapport financier au style impeccable, alors n’importe quelle entité douteuse le peut aussi. Cela ouvre la porte aux entreprises mal gérées qui s’approprient cette technologie pour masquer leurs incompétences derrière une prose rassurante.

L’outil devient un redoutable masque de crédibilité. Il permet à des acteurs opportunistes de mimer à la perfection le langage des firmes sérieuses, rendant la détection des supercheries ou des faiblesses structurelles infiniment plus complexe.

Le risque est l’érosion totale de la confiance. Nous glissons vers un marché où distinguer une communication authentique d’une façade générée par algorithme relève de la gageure, laissant les parties prenantes dans le brouillard.

La perte de l’empreinte managériale

Il ne faut pas oublier que le style propre d’un dirigeant constitue une donnée capitale. Les analystes scrutent cette phraséologie pour y lire des intentions non-dites ; c’est ce qu’on appelle l’empreinte managériale, indicateur de la psychologie du leadership.

Or, l’utilisation de l’IA pour rédiger à la place des décideurs efface radicalement cette trace. Elle lisse la personnalité, gomme l’émotion et supprime ces tics de langage révélateurs qui permettaient de comprendre l’homme derrière la fonction.

Nous perdons là une couche d’analyse précieuse. La communication devient désincarnée, froide, et paradoxalement moins digne de confiance, car elle manque cruellement de cette humanité faillible qui rendait le discours crédible aux yeux des experts.

Le casse-tête réglementaire et la gouvernance des données

Au-delà des fuites stratégiques, l’utilisation de l’IA dans les communications d’entreprise ouvre une véritable boîte de Pandore sur le plan légal.

Stratégique vs personnel : une distinction que l’IA ignore

Les plans de développement ou les prévisionnels financiers échappent souvent à la définition stricte des données personnelles du RGPD. Pourtant, leur divulgation cause des dommages bien plus profonds qu’une simple fuite d’adresse email. La valeur critique de ces informations reste scandaleusement sous-estimée par les entreprises.

Le problème majeur réside dans l’incapacité technique de l’algorithme à faire le tri entre les types d’informations. Pour une IA, une stratégie de fusion confidentielle n’est qu’un ensemble de données comme un autre. Elle va donc mélanger données stratégiques et personnelles dans ses analyses sans aucune hésitation.

L’usage d’outils grand public type ChatGPT sans contrat de traitement de données (DPA) aggrave considérablement la situation. L’entreprise s’expose alors simultanément à une perte sèche de savoir-faire et à une violation réglementaire. C’est une double peine juridique quasi inévitable pour les imprudents.

Les nouveaux visages du risque de divulgation

Les menaces pesant sur l’ia communication entreprise ont muté radicalement ces derniers mois. Protéger les bases de données ne suffit plus quand le danger vient de l’inférence algorithmique. Il faut désormais surveiller chaque flux d’information sortant avec une paranoïa justifiée.

| Critère | Risques traditionnels (Avant l’IA) | Nouveaux risques (Avec l’IA) |

|---|---|---|

| Source du risque | Fuite de documents (rapports, emails), espionnage industriel classique | Inférence à partir de données publiques anodines, « mémoire » des LLM, analyse des logs de requêtes. |

| Type de données exposées | Données structurées et confidentielles (financières, R&D) | Données non structurées, signaux faibles, intentions stratégiques, culture d’entreprise. |

| Vecteur d’attaque | Hacking de serveurs, ingénierie sociale ciblée | Requêtes intelligentes sur des IA publiques, analyse croisée de sources multiples, soumission de données sensibles à des IA tierces. |

| Impact principal | Perte financière directe, atteinte à la réputation | Perte d’avantage concurrentiel, mauvaise interprétation par les marchés, érosion de la confiance. |

L’IA et le RGPD : un cocktail explosif

L’externalisation du traitement vers une IA américaine pose un problème de souveraineté immédiat et inquiétant. Cela constitue souvent un transfert de données personnelles hors de l’Union Européenne sans les garanties nécessaires. Sans une base légale solide, l’infraction au RGPD est caractérisée. Les régulateurs ne tolèrent plus cette légèreté coupable.

Les historiques de conversation, ou « logs », agissent comme une bombe à retardement silencieuse au cœur du système d’information. Ils stockent des fragments de secrets industriels ou d’identités clients sur des serveurs souvent inconnus. La traçabilité de ces données devient alors totalement impossible pour les équipes techniques.

La direction juridique doit impérativement se saisir de ce dossier brûlant avant qu’il ne soit trop tard. La friction complexe entre l’IA et la RGPD représente aujourd’hui le risque de conformité le plus élevé. Ignorer cette réalité expose les dirigeants à des sanctions financières lourdes.

Reprendre le contrôle : stratégies de défense et gouvernance

La gouvernance avant la technologie

Ne cherchez pas le salut dans un énième logiciel miracle. La réponse est d’abord structurelle. Il faut imposer un cadre de gouvernance strict pour endiguer les fuites. Souvent, l’échec des projets d’IA découle d’un organigramme bancal.

Vos équipes manipulent de la dynamite sans le savoir. Elles doivent saisir les dangers des modèles publics. C’est pourquoi il devient urgent de se former à l’intelligence artificielle.

L’organisation reste le véritable verrou de sécurité. Beaucoup d’initiatives s’effondrent, non par défaut technique, mais parce que l’échec des projets d’IA provient d’une structure inadaptée.

Les piliers d’une politique de protection efficace

Une doctrine floue mène droit au désastre. Vous devez dicter qui accède à quoi. La classification des données devient dès lors non-négociable pour la survie de l’entreprise.

- Politique d’utilisation acceptable : Listez noir sur blanc les outils IA tolérés et leurs usages proscrits.

- Classification rigoureuse des données : Triez chaque information, du public au confidentiel, avant toute ingestion par une machine.

- Politique de « Zero Data Retention » : Exigez des solutions privées garantissant qu’aucune trace ne subsiste après le traitement.

- Validation humaine systématique : Interdisez toute publication générée par IA sans la relecture d’un expert humain.

Les barrières techniques indispensables

Les règles écrites ne suffisent pas face aux failles. Le chiffrement systématique des données, qu’elles soient en transit ou utilisées, constitue le socle minimal. C’est votre dernier rempart.

L’architecture multi-locataire pose un risque de contagion. Il faut un isolement hermétique pour qu’aucune donnée ne « bave » d’un client à l’autre via le modèle. C’est une question d’étanchéité.

Éparpiller vos données est une erreur stratégique. Misez sur des plateformes unifiées et intégrées qui verrouillent les flux, plutôt que de multiplier les outils tiers incontrôlables.

Bâtir la confiance à l’ère de la suspicion algorithmique

La transparence comme seule arme

Face à la méfiance généralisée, le silence constitue la pire des stratégies, s’apparentant à un aveu de faiblesse. Les entreprises doivent impérativement se montrer proactives sur leur usage de l’IA, car dissimuler ces outils ne fait qu’alimenter une suspicion légitime.

Il devient nécessaire de communiquer sans ambiguïté sur sa politique de gouvernance des données. Montrer patte blanche n’est plus une option, c’est un véritable avantage concurrentiel pour rassurer les marchés.

Cette exigence de clarté ne souffre aucune exception : elle doit s’appliquer tant aux algorithmes scrutant le marché qu’aux systèmes potentiellement utilisés pour générer du contenu ou des rapports financiers.

Démontrer la supervision humaine

La technologie ne doit jamais éclipser le jugement humain. La confiance des parties prenantes ne perdurera que si elles ont la certitude qu’un expert reste le décisionnaire final ; l’IA demeure un instrument, jamais le pilote.

Cela implique de mettre en lumière les mécanismes rigoureux de validation, de relecture et de contrôle. L’humain doit rester visible et identifiable à chaque étape de la chaîne de communication.

L’objectif est de prouver que l’organisation ne subit pas la dictature technologique, mais qu’elle la pilote de manière responsable et éclairée, avec une conscience aiguë des risques inhérents.

Les principes d’une communication digne de confiance

Pour maintenir la confiance des investisseurs et partenaires face aux défis de l’ia communication entreprise, l’adoption de pratiques rigoureuses s’impose comme un rempart nécessaire.

- Authenticité assumée : Ne cherchez pas à cacher l’usage de l’IA, mais expliquez-la ; une communication authentique, même imparfaite, vaut mieux qu’un discours générique.

- Responsabilité claire : Désignez systématiquement un responsable humain pour chaque communication, car l’IA ne peut être tenue pour responsable.

- Traçabilité démontrable : Prouvez l’origine des données utilisées, le traitement appliqué et expliquez la logique des décisions de communication.

- Éducation continue : Communiquer régulièrement sur les mesures d’encadrement prises montre que le sujet est une préoccupation constante.

L’ère de l’innocence numérique est révolue : chaque donnée publique devient une faille potentielle exploitable par l’intelligence artificielle. Face à cette transparence forcée, la survie des entreprises repose désormais sur une gouvernance impitoyable de l’information. Seule une supervision humaine rigoureuse permettra de préserver la confiance dans un écosystème où le silence n’est plus une option viable.