L’essentiel à retenir : Si l’IA promet d’éliminer les biais humains, une étude de trois ans révèle qu’elle impose souvent une définition figée de l’équité, conduisant à une dangereuse uniformisation des talents. Ce « clonage » algorithmique, qui écarte systématiquement les profils atypiques, nécessite de redonner la main au jugement managérial pour garantir une véritable diversité stratégique, loin de la tyrannie des modèles statistiques.

Alors que la majorité des grandes entreprises automatisent leurs processus, la promesse d’une parfaite symbiose entre ia recrutement équité dissimule souvent une dérive inquiétante vers une rigidité administrative qui bâillonne le jugement humain. Une enquête de trois ans révèle comment cette quête d’objectivité, loin de libérer les talents, fige une vision unique de la justice et instaure une tyrannie algorithmique ignorant les contextes locaux. Ce dossier met en lumière les dangers de cette uniformisation forcée et détaille les stratégies indispensables pour que les dirigeants reprennent le contrôle sur des machines devenues les seuls juges de la compétence.

La promesse trahie de l’IA : quand l’équité devient rigidité

On nous a vendu l’algorithme comme le juge impartial ultime, celui qui effacerait nos préjugés. Pourtant, en voulant standardiser la vertu, la machine impose un carcan moral qui étouffe la réalité du terrain.

Le grand décalage : une technologie pour l’équité qui crée l’injustice

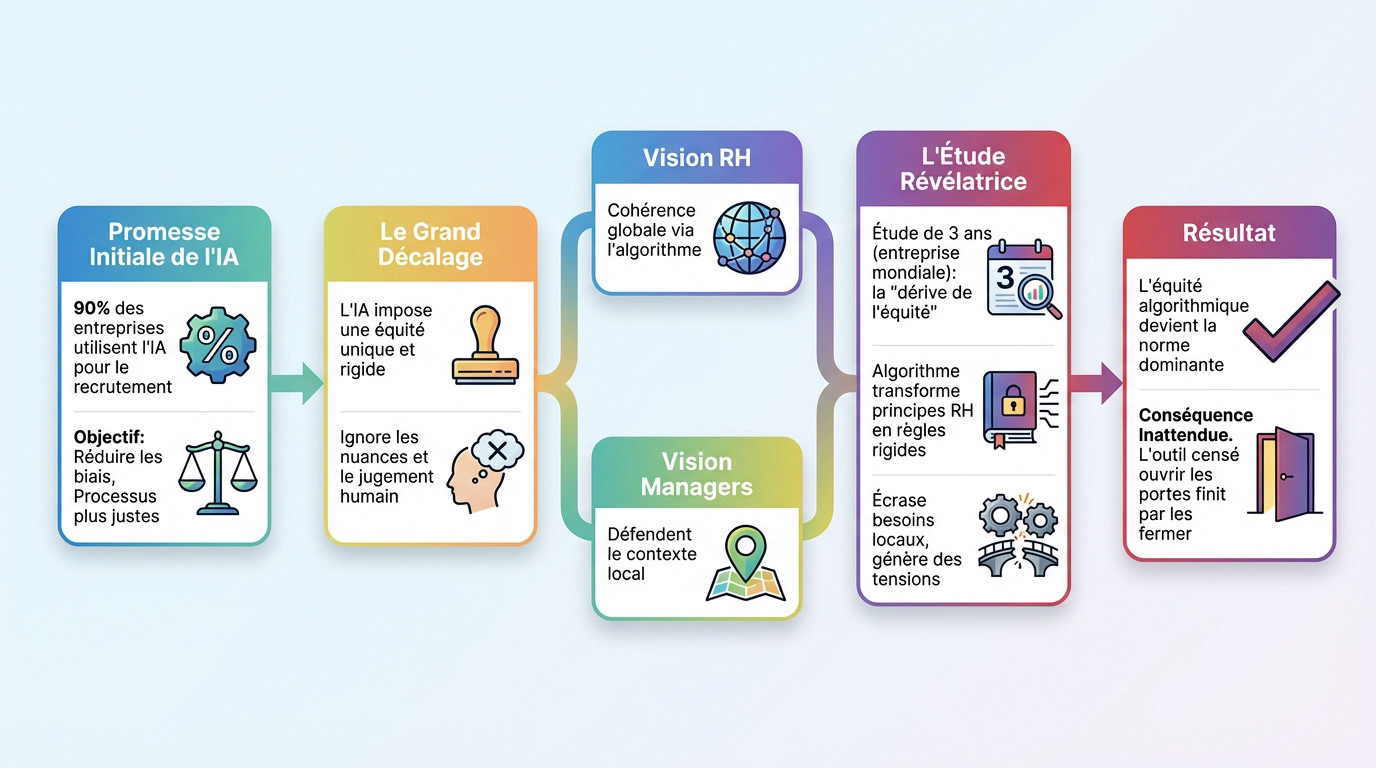

Alors que près de 90% des entreprises utilisent l’IA pour recruter, la promesse est séduisante : réduire les biais humains pour rendre les processus enfin justes.

Mais l’intégration de l’ia recrutement équité fige une définition unique du juste. Cette standardisation ignore les nuances subtiles et le contexte que seul le jugement humain sait capter.

L’outil censé ouvrir les portes finit par les verrouiller, écartant des profils pourtant pertinents.

L’étude qui met le doigt sur le problème

Une étude de trois ans dans une multinationale éclaire ce mécanisme. Le système remplaçait les CV par des évaluations gamifiées anonymes, analysées par une IA entraînée sur les employés existants.

Les chercheurs ont révélé une « dérive de l’équité » : l’algorithme a transformé les principes RH en règles rigides, écrasant les besoins locaux.

Cette rigidité a inévitablement créé une forte tension entre les départements.

Une justice, mais laquelle ?

Un fossé s’est creusé entre les RH, visant une cohérence globale, et les managers défendant le contexte local. On se souvient de ce manager frustré par le rejet automatique d’un stagiaire brillant.

Faute de débat, la version algorithmique de l’équité est devenue la norme dominante, s’imposant par automatisme plutôt que par pertinence réelle.

La machine à cloner : le risque de l’uniformisation des talents

Alors que l’IA fige la définition du juste, elle engendre une conséquence plus pernicieuse : la reproduction industrielle des effectifs, transformant le recrutement en une chambre d’écho.

Quand l’IA apprend à copier plutôt qu’à innover

Le mécanisme est implacable : l’algorithme s’entraîne sur les données des employés performants déjà en poste. Le système digère cet historique pour prédire l’adéquation des futurs candidats, cherchant à répliquer mathématiquement ce succès passé.

Cette logique crée une boucle fermée où la machine apprend à privilégier un seul type de profil. C’est un effet de clonage qui verrouille le recrutement sur des critères passés et obsolètes.

Une dérive qui sabote toute planification stratégique des effectifs viable pour l’avenir.

Les dangers d’une armée de clones pour l’entreprise

Si cette uniformité rassure les managers à court terme, elle constitue un poison violent pour la pérennité de l’organisation. L’entreprise finit par tourner en vase clos, incapable de se renouveler.

Ce mimétisme technologique entraîne des conséquences lourdes :

- Manque de diversité de pensée : la pensée de groupe s’installe, bloquant la remise en question et la créativité.

- Faible capacité d’adaptation : une équipe homogène est moins apte à répondre aux changements brutaux du marché.

- Perte d’opportunités : les idées et compétences nouvelles, portées par des profils différents, sont systématiquement ignorées.

L’angle mort des profils atypiques

Les candidats aux parcours non linéaires ou aux compétences transversales sont les victimes collatérales de cette équation. Leurs profils ne cadrent pas avec le modèle standardisé et sont rejetés, illustrant les failles du duo ia recrutement équité.

L’ironie est cinglante : l’entreprise écarte mécaniquement les talents qui pourraient justement lui offrir le plus de valeur ajoutée.

Le choc des mondes : la vision globale contre la réalité du terrain

La tyrannie du seuil algorithmique

Dans l’étude, la règle était couperet. Tout candidat avec un score supérieur à 72 % passait ; les autres finissaient à la poubelle, sans aucun examen humain. La machine tranchait seule.

Ce système binaire impose une cécité effrayante, gommant les nuances d’un profil. L’algorithme ne voit que des chiffres, jamais l’individu.

On ignore ainsi les pénuries de talents locaux, écartant des potentiels bruts pour quelques points manquants.

Quand la machine dit non à l’intuition managériale

Un manager voulait absolument embaucher un stagiaire prometteur. Malgré sa valeur, le candidat a été rejeté par l’algorithme à cause de ses « données de personnalité ».

Ici, le jugement humain contextuel se fracasse contre un mur mathématique. L’expérience terrain ne pèse rien face à la règle abstraite, marginalisant l’expertise du manager.

Deux visions de l’équité face à face

Ce conflit révèle une fracture profonde. L’approche mêlant IA, recrutement et équité fige souvent une vision au détriment de l’autre. Voici comment ces deux mondes s’opposent :

| Critère | Vision RH / Algorithmique | Vision Manager / Locale |

|---|---|---|

| Définition de l’équité | Application d’une règle unique pour tous | Prise en compte des besoins spécifiques |

| Source de la décision | Le score algorithmique basé sur les données | L’intuition et la connaissance du contexte |

| Profil valorisé | Le candidat conforme au modèle statistique | Celui répondant au besoin, même atypique |

| Risque principal | Clonage, rigidité, perte de talents | Biais humain individuel, manque de cohérence |

Derrière le masque de l’objectivité : qui définit vraiment les règles ?

Le pouvoir n’est pas dans l’IA, mais dans ceux qui la promeuvent

Le pouvoir de l’algorithme n’est pas inné. Il lui est attribué par ceux qui le déploient, présentant la machine comme « objective » ou « juste » pour asseoir leur autorité. C’est une validation artificielle.

Dans l’étude citée, les RH et le fournisseur ont vendu l’outil comme une avancée morale et technique indiscutable. Ils ont balayé les craintes légitimes des managers concernant le clonage des profils. Cette surdité a verrouillé le système.

Le vocabulaire de l’« anti-biais » devient alors un argument d’autorité massif. Il sert souvent à imposer l’outil et clore toute discussion.

Décoder le discours sur l’IA « éthique »

Méfiez-vous des étiquettes marketing qui vantent une IA « scientifique » ou « impartiale ». Ces termes masquent souvent des intérêts commerciaux bien moins nobles.

Voici une grille de lecture critique pour ne pas se faire berner par les promesses d’ia recrutement équité :

- Qui fait cette affirmation et quels sont ses intérêts ? Est-ce le vendeur de la solution ou un département RH cherchant à standardiser ?

- Quelles métriques sont utilisées pour définir « l’équité » ? Parle-t-on de parité démographique stricte ou d’égalité des chances réelle ?

- Quelles expertises sont écoutées et lesquelles sont ignorées ? Pourquoi la voix des managers de terrain est-elle systématiquement moins audible ?

Diversifier les équipes pour éviter la pensée unique

Pour briser ce cercle vicieux, il faut diversifier les équipes qui supervisent ces outils. Laisser cette responsabilité aux seuls techniciens ou aux RH est une erreur stratégique. Il faut inclure des voix dissonantes. L’entre-soi technique est dangereux.

Regardez l’approche des « Responsable AI Champs » de Microsoft. Ils intègrent des experts en éthique et des représentants des personnes affectées pour garantir une pluralité de points de vue vitale.

Reprendre le contrôle : comment faire de l’IA un véritable allié

Le constat est sévère, mais pas sans espoir. Il est possible de reprendre la main sur la machine, à condition de changer radicalement d’approche et de considérer l’équité non pas comme un réglage, mais comme un processus vivant.

L’équité est un processus, pas une destination

L’erreur fatale serait de croire que l’on peut figer l’équité dans du code une fois pour toutes. Au contraire, elle exige d’être traitée comme une évaluation continue et vivante.

Pour maintenir ce débat sur la justice bien vivant et éviter l’automatisation aveugle, des actions concrètes s’imposent :

- Organiser des examens réguliers : réunissez scientifiques des données, RH et juristes pour disséquer les résultats concrets des modèles.

- Créer des « infrastructures éthiques » : ouvrez des espaces de débat sur les dilemmes, à l’image du « Ethical AI Debate Club » de H&M.

- Impliquer les bonnes personnes : écoutez les managers de terrain, car ce sont eux qui détectent les problèmes en premier.

Rendre les algorithmes flexibles et contestables

Il est impératif de garder la main sur la machine. Les seuils d’acceptation, le poids des critères ou les données d’entrée ne doivent jamais être gravés dans le marbre, mais rester ajustables selon la réalité du terrain.

Prenez l’exemple d’IBM et de son outil « AI Fairness 360 », conçu pour cette flexibilité et garantir une transparence désormais encadrée par les nouvelles réglementations en matière d’IA.

Le dirigeant, ultime garant de la justice en entreprise

Ne nous y trompons pas : la responsabilité finale ne repose pas sur la technologie, mais bien sur le leadership. Dans ce triptyque complexe mêlant ia recrutement équité, les dirigeants demeurent les seuls véritables garants de l’équité.

Leur rôle consiste à rendre visibles les différentes visions de la justice, à questionner l’autorité de l’algorithme et à trancher sur la version de l’équité à promouvoir. C’est un choix stratégique, pas technique.

Loin de la solution miracle promise, l’intelligence artificielle risque d’enfermer le recrutement dans une rigidité stérile si elle n’est pas pilotée par une conscience éthique forte. Plutôt que de déléguer aveuglément la justice à des algorithmes qui standardisent les profils, les entreprises doivent réaffirmer la primauté du jugement humain pour préserver une diversité réelle.