L’essentiel à retenir : Loin du mythe de la dématérialisation, l’intelligence artificielle dévore énergie et ressources naturelles à un rythme insoutenable. Cette boulimie, dont l’empreinte carbone dépasse désormais celle de la France, impose une transition urgente vers la sobriété numérique pour éviter des conflits d’usage majeurs sur l’eau et l’électricité.

Alors que l’adoption massive des algorithmes génératifs s’accélère, l’impact environnemental intelligence artificielle soulève une inquiétude grandissante quant à l’épuisement irréversible de nos réserves mondiales en eau et en énergie. Ce dossier met en lumière la facture cachée de cette révolution numérique, exposant sans détour la voracité matérielle des centres de données qui rivalisent désormais avec la consommation électrique de nations entières. Une analyse rigoureuse vous attend pour comprendre comment, derrière l’écran, cette industrie insatiable risque de transformer nos territoires en zones sacrifiées sur l’autel du progrès technologique.

- La boulimie énergétique de l’ia : une facture électrique qui explose

- Une soif insatiable : la consommation d’eau cachée derrière le cloud

- Le lourd tribut matériel : métaux rares et obsolescence programmée

- L’artificialisation des sols : quand les data centers dévorent le paysage

- La face cachée de la continuité : la pollution locale des générateurs diesel

- L’empreinte carbone : un bilan qui dépasse déjà celui de la France

- Vers une ia plus sobre ? les pistes pour un futur moins énergivore

La boulimie énergétique de l’ia : une facture électrique qui explose

Vous pensez que le numérique est immatériel ? Détrompez-vous. L’impact environnemental intelligence artificielle est une réalité physique brutale qui menace de mettre nos réseaux électriques à genoux si nous n’y prenons pas garde immédiatement.

Des centres de données plus gourmands que des réacteurs nucléaires

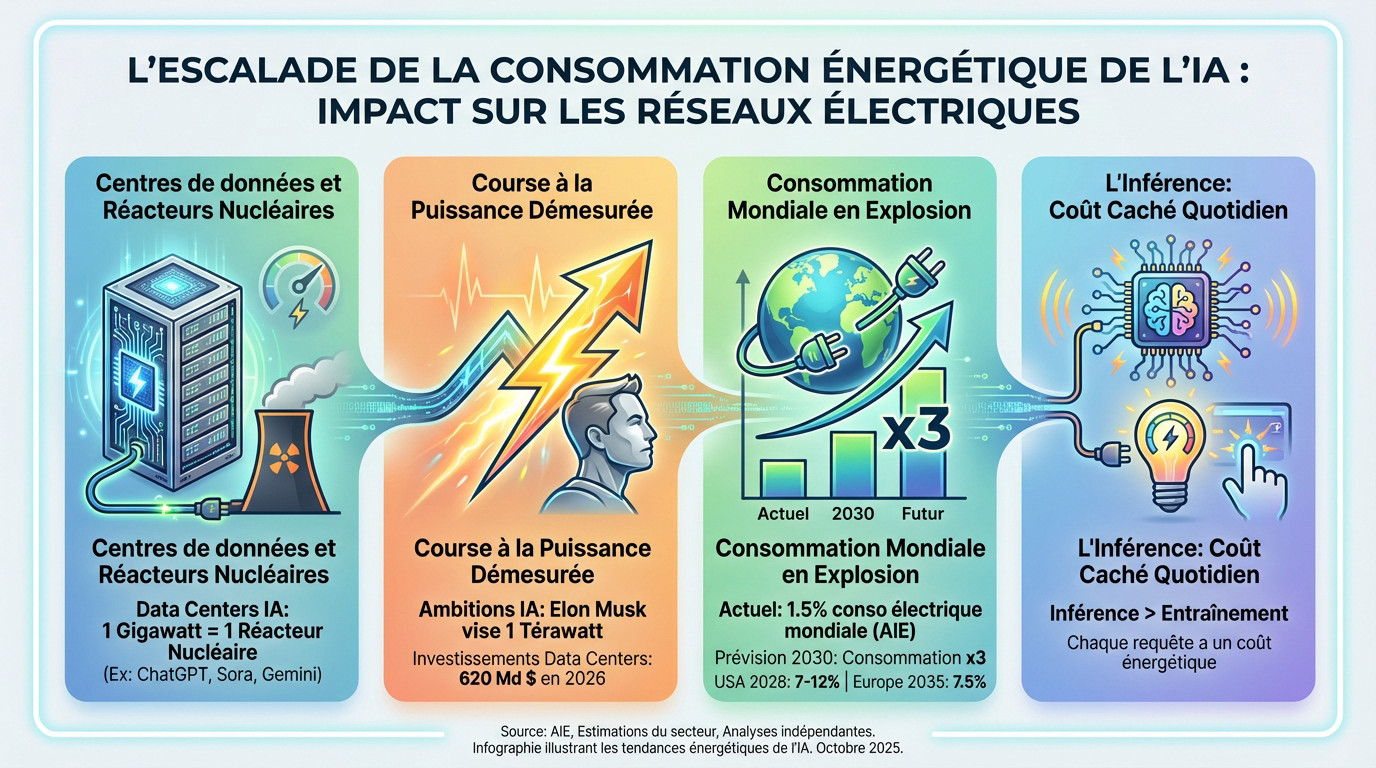

Google, OpenAI et Microsoft s’engagent dans une course effrénée au gigantisme avec des outils comme ChatGPT, Sora ou Gemini. Cette rivalité technologique impose la construction de méga-centres de données dont les plus massifs visent désormais une capacité effarante de 1 gigawatt.

Pour saisir l’ampleur du délire, ce chiffre équivaut à la production électrique d’un réacteur nucléaire complet. C’est une aberration totale de penser qu’une seule infrastructure privée puisse engloutir autant d’énergie qu’une centrale entière.

Cette demande vorace fait peser une menace réelle de pénuries sur nos réseaux nationaux, risquant de déclencher de violents conflits d’usage pour l’accès à l’électricité.

La course à la puissance : des ambitions démesurées

L’exemple le plus frappant reste celui d’Elon Musk avec sa société xAI, qui ne semble connaître aucune limite. Il évoque sans sourciller des ambitions délirantes de 10 GW, puis 100 GW pour alimenter ses infrastructures.

Son objectif ultime frôle la science-fiction : atteindre 1 térawatt de puissance de calcul. Une telle demande énergétique, si elle se concrétisait, serait tout simplement insoutenable pour nos infrastructures actuelles et témoigne d’une irresponsabilité flagrante face aux enjeux climatiques.

Cette fuite en avant se traduit financièrement : les investissements dans ces centres de données devraient grimper à 620 milliards de dollars, une somme astronomique.

Une consommation mondiale qui pourrait tripler d’ici 2030

Actuellement, l’Agence Internationale de l’Énergie estime que les centres de données accaparent environ 1,5% de la consommation électrique mondiale. Ce chiffre, qui paraît modeste, n’est que le prélude au désastre annoncé.

Les projections donnent le vertige : la consommation annuelle de ces sites pourrait tripler d’ici 2030. Aux États-Unis, épicentre de cette technologie, elle engloutirait entre 7% et 12% de l’électricité totale du pays dès 2028.

Le Vieux Continent n’est pas épargné, puisque l’Europe pourrait voir ces infrastructures drainer 7,5% de la consommation d’ici 2035. C’est bien l’essor incontrôlé de l’IA qui alimente cette courbe exponentielle.

L’inférence, le coût caché de nos requêtes quotidiennes

On blâme souvent l’entraînement des modèles, mais c’est l’inférence — l’utilisation réelle — qui pose problème. Si former une IA est coûteux, l’impact de l’usage quotidien par des milliards d’utilisateurs reste largement sous-estimé par le grand public.

Les données récentes le prouvent : pour les IA génératives, l’impact de l’inférence dépasse aujourd’hui celui de l’entraînement. Chaque question posée à un chatbot a un coût énergétique tangible et immédiat.

C’est donc bien la banalisation de ces outils dans nos vies qui agit comme le véritable moteur.

Une soif insatiable : la consommation d’eau cachée derrière le cloud

Mais l’électricité n’est pas la seule ressource que l’IA dévore sans compter. Une autre, tout aussi vitale, est consommée dans des proportions astronomiques : l’eau.

Des milliards de litres pour refroidir les serveurs

Vous pensez que le Cloud est immatériel ? Détrompez-vous, car pour empêcher les serveurs de fondre sous l’effort de calcul 24h/24, le refroidissement des serveurs est le nerf de la guerre. C’est une infrastructure physique lourde qui siphonne nos réserves.

Les chiffres donnent le vertige. En 2023, la consommation réelle a été estimée à 560 milliards de litres. Imaginez un instant : c’est une quantité d’eau colossale qui s’évapore juste pour maintenir la machine en marche.

Le pire est à venir selon l’AIE, qui prévoit un doublement d’ici 2030, atteignant 1 200 milliards de litres par an. Une fuite en avant incontrôlée.

Le paradoxe de l’eau : prélever dans des zones de pénurie

Voici un aspect qui ressemble à un coup de poignard dans le dos des communautés locales. Les géants de la tech installent souvent leurs méga-usines de données là où l’or bleu est déjà une ressource sous tension extrême.

Prenez Google, par exemple. Leurs propres documents révèlent que 14% de l’eau utilisée par l’entreprise provient de zones identifiées à risque élevé de pénurie. C’est une aberration écologique.

Cette prédation crée inévitablement des conflits d’usage majeurs, opposant les besoins de l’IA à ceux de l’agriculture et des populations.

La fabrication des puces, un processus assoiffé

L’hémorragie ne s’arrête pas à l’exploitation. En amont, la fabrication même du matériel nécessaire à l’IA est très intensive en eau, exigeant une pureté absolue pour nettoyer les composants.

Regardez du côté de TSMC, le leader incontesté des semi-conducteurs. Il faut plus de 7 000 litres d’eau pour produire un seul « wafer » de silicium de 12 pouces. Une soif industrielle qui défie l’entendement.

Sachant que TSMC fabrique 16 millions de wafers par an, le volume est titanesque. Certes, ils recyclent 88% de leur eau, mais le prélèvement initial reste gigantesque.

L’opacité des géants de la tech sur leur consommation réelle

Ce qui agace le plus, c’est le silence. Les entreprises de la tech cultivent un flou artistique sur leurs chiffres précis, rendant l’évaluation globale de leur impact aussi difficile que de trouver une aiguille dans une botte de foin.

Il faut distinguer ce qui est consommé de ce qui est prélevé. Les prélèvements en 2023 auraient dépassé 5 000 milliards de litres, un chiffre bien plus effrayant que la consommation nette affichée.

Cette opacité structurelle empêche toute véritable prise de conscience collective concernant l’empreinte hydrique de l’IA et ses conséquences à long terme.

Le lourd tribut matériel : métaux rares et obsolescence programmée

Au-delà de l’énergie et de l’eau, l’appétit de l’IA se porte sur la matière elle-même. Pour fonctionner, elle a besoin d’un squelette matériel dont la fabrication et le renouvellement ont un coût environnemental exorbitant. C’est précisément là que l’impact environnemental intelligence artificielle devient critique, révélant une facette souvent ignorée du progrès technologique.

Les gpu, des concentrés de métaux critiques

Les cartes graphiques (GPU) constituent le véritable cerveau matériel de l’IA. Si ces composants sont des bijoux de technologie, ils représentent aussi de redoutables bombes à retardement écologiques. Leur production exige une extraction minière intensive. Vous voyez le désastre arriver.

Prenez une seule carte Nvidia A100, c’est effrayant. Elle contient plus de vingt métaux différents pour fonctionner. La plupart sont des matériaux rares ou critiques difficiles à obtenir.

- Quelques métaux critiques nécessaires à la fabrication d’un GPU : Cuivre, Or, Argent, Tantale, Cobalt, Gallium, Germanium. L’extraction de ces métaux est souvent polluante et socialement problématique.

Une industrie des semi-conducteurs en surchauffe

Ce secteur connaît une croissance explosive qui donne le vertige. L’industrie des semi-conducteurs pourrait doubler en cinq ans à peine. Cette frénésie est directement tirée par la demande insatiable de l’IA. On ne s’arrête plus.

Regardez les chiffres du marché des GPU et puces dédiées à l’IA. Il devrait dépasser 280 milliards de dollars d’ici 2029. C’est une course financière sans précédent.

Cet essor illustre parfaitement l’impact de l’IA sur le marché des logiciels et du matériel. Tout le secteur est bouleversé.

L’obsolescence accélérée, le moteur de la pollution électronique

Il y a un angle mort que personne ne veut voir. La course à la performance pousse à un renouvellement constant des équipements. On jette le vieux pour du neuf. C’est un gaspillage immense.

La durée de vie des serveurs dédiés à l’IA est 3 à 5 fois plus courte que celle des serveurs traditionnels. Ils s’usent beaucoup trop vite. C’est un fait avéré.

Cette obsolescence accélérée génère une montagne de déchets électroniques (e-waste) hautement polluants et difficiles à recycler. Le bilan est lourd.

La géopolitique des ressources, une tension sous-jacente

La dépendance aux métaux rares et aux semi-conducteurs crée de fortes tensions géopolitiques. La production mondiale est concentrée dans quelques pays seulement. Cela rend l’approvisionnement très risqué. Tout peut basculer rapidement.

Regardez la chaîne de valeur avec TSMC à Taïwan, Nvidia aux USA. Sa fragilité face aux crises internationales est évidente. Un seul grain de sable suffit.

La course à l’IA exacerbe la compétition mondiale pour le contrôle de ces ressources finies. C’est une guerre économique.

L’artificialisation des sols : quand les data centers dévorent le paysage

On assiste actuellement à une course effrénée et inquiétante vers le gigantisme immobilier pour soutenir l’IA. Les investissements massifs dans les centres de données explosent littéralement aujourd’hui. Aux États-Unis, ces dépenses sont sur le point de dépasser ceux des bureaux traditionnels. C’est un basculement économique historique et révélateur.

Cette frénésie de construction se traduit par une artificialisation massive des sols partout sur le globe. On ne parle plus de simples salles serveurs, mais de complexes industriels s’étendant sur des kilomètres carrés. Le béton remplace la nature.

Chaque nouveau chantier scelle le sort de terres agricoles précieuses. Cette destruction de l’espace naturel est souvent irréversible.

Des projets pharaoniques qui redessinent les territoires

Regardez le cas du projet Stargate d’OpenAI prévu au Texas. Ce véritable monstre de béton prévoit d’occuper 4,5 km² de bâtiments. C’est une échelle industrielle qui dépasse l’entendement humain.

Le méga data center Hyperion de Meta en Louisiane n’est pas en reste non plus. Il pourrait couvrir une « partie importante de la superficie de Manhattan ». L’ambition de ces firmes est sans limite.

Pour visualiser le gigantisme :

- Le projet Stargate est plus grand que Central Park à New York.

- Le projet Hyperion pourrait couvrir une surface comparable à plusieurs arrondissements de Paris.

- Ces projets ne sont pas des exceptions, mais la nouvelle norme.

L’empreinte au sol en France : l’équivalent de 1 680 terrains de football

La France n’échappe pas à cette boulimie foncière mondiale qui inquiète les observateurs. Le gouvernement a déjà identifié 35 sites favorables pour accueillir ces usines numériques. L’État déroule le tapis rouge pour ces infrastructures critiques, ignorant parfois l’impact environnemental.

Mis bout à bout, ces projets représentent une emprise totale de 12 km² de terres. C’est une surface considérable arrachée à notre patrimoine foncier.

Pour vous donner une idée précise, cela correspond à 1 680 terrains de football. L’image est brutale mais réelle.

Des conflits d’usage qui se profilent à l’horizon

Cette absorption de ressources vitales ne se fait pas sans heurts majeurs pour les populations locales. L’eau et l’énergie accaparées créent une compétition directe avec nos besoins essentiels. Nous entrons dans une ère de rivalité féroce pour l’accès aux ressources.

Les tensions montent déjà avec l’agriculture, le logement et la préservation de la biodiversité. On ne peut pas manger des données ni vivre dans des serveurs. Les priorités s’entrechoquent.

Ce n’est plus un débat technologique abstrait. C’est devenu un enjeu majeur d’aménagement du territoire pour notre avenir.

La face cachée de la continuité : la pollution locale des générateurs diesel

Et si la menace la plus directe pour l’environnement et la santé n’était pas visible sur la facture d’électricité, mais se cachait dans les coulisses de ces forteresses numériques ?

Les groupes électrogènes, l’assurance vie polluante des data centers

Pour garantir une continuité de service absolue et éviter le moindre temps d’arrêt, chaque data center est équipé de générateurs de secours massifs. Ces infrastructures critiques dissimulent une réalité industrielle lourde, prête à s’activer instantanément en cas de défaillance du réseau.

Le problème réside dans le fait que ces générateurs fonctionnent massivement au diesel, un combustible fossile particulièrement polluant. Ce choix technologique privilégie la fiabilité brute au détriment de la qualité de l’air.

Leur rôle est double : ils doivent prendre le relais en cas de panne de courant et être testés régulièrement.

Des tests réguliers qui empoisonnent l’air local

Même sans panne majeure, ces générateurs sont démarrés fréquemment, souvent mensuellement, pour s’assurer de leur bon fonctionnement mécanique. Cette routine de maintenance, invisible pour l’utilisateur final, génère une activité polluante constante autour des sites.

Cela implique des rejets massifs de particules fines, d’oxydes d’azote et d’autres polluants atmosphériques nocifs. À chaque allumage, ces machines libèrent un cocktail toxique directement dans l’atmosphère.

Cette pollution est directe, locale et récurrente, affectant immédiatement la qualité de vie des riverains.

La justice environnementale, grande oubliée de l’équation ia

Il existe un lien troublant entre cette pollution locale et la notion de justice environnementale, car les data centers sont souvent implantés près de communautés défavorisées. Ces zones, où le foncier est moins onéreux, deviennent des points chauds d’émissions toxiques.

Ce sont ces populations qui subissent de plein fouet les conséquences sanitaires de la pollution de l’air, payant le prix fort de notre consommation numérique.

Le « progrès » technologique de l’IA se fait ainsi, cyniquement, au détriment de la santé des plus vulnérables.

Un impact direct sur la santé des communautés riveraines

La pollution atmosphérique générée par les diesels est liée à des maladies respiratoires comme l’asthme, des problèmes cardiovasculaires et des cancers, selon de nombreuses études épidémiologiques. Les particules fines pénètrent profondément dans les poumons, causant des dommages irréversibles sur le long terme.

On constate l’apparition de smog et une dégradation générale de la qualité de l’air dans les zones concernées par ces installations.

L’impact environnemental intelligence artificielle n’est pas qu’une statistique globale, mais une réalité tangible et nocive pour de nombreuses personnes.

L’empreinte carbone : un bilan qui dépasse déjà celui de la France

Une dépendance massive aux énergies fossiles

Il faut briser le mythe d’une technologie dématérialisée et propre, car l’impact environnemental intelligence artificielle repose sur une réalité physique lourde. Ces infrastructures exigent une alimentation électrique continue que les énergies renouvelables intermittentes peinent à garantir seules.

La réalité des réseaux électriques est implacable : plus de la moitié de l’électricité qui alimente les centres de données à l’échelle mondiale provient encore d’énergies fossiles, principalement du charbon et du gaz.

Dès lors, chaque requête adressée à une IA générative déclenche, par un effet domino énergétique, une émission directe de CO₂.

Des émissions de gaz à effet de serre qui s’envolent

L’appétit insatiable des modèles génératifs laisse présager une catastrophe climatique, car la croissance des émissions de gaz à effet de serre (GES) des data centers pourrait doubler, voire tripler à court terme. Cette trajectoire ascendante contredit tous les engagements de sobriété.

Les estimations pour l’année 2024 sont sans appel et glacent le sang : les émissions du secteur pourraient atteindre le seuil critique de 369 millions de tonnes équivalent CO₂.

Ce volume colossal représente déjà plus que les émissions annuelles totales de la France, qui plafonnaient récemment autour de 339 millions de tonnes.

Visualiser l’impact : une comparaison qui donne le vertige

Plutôt que de se perdre dans des abstractions chiffrées, un tableau comparatif permet de saisir la brutalité de l’accaparement des ressources.

| Ressource | État Actuel (2023-2025) | Projection (2030-2035) | Équivalent à l’échelle humaine |

|---|---|---|---|

| Électricité | 1,5% de la conso. mondiale (AIE) | Jusqu’à 7,5% en Europe (2035) | La consommation de plusieurs pays européens réunis |

| Eau | 560 milliards de litres/an | 1 200 milliards de litres/an | La consommation d’eau potable d’un pays comme le Royaume-Uni |

| CO₂ | ~369 Mt éq. CO₂ (2024) | Potentiellement > 700 Mt éq. CO₂ | Les émissions annuelles de l’aviation civile mondiale pré-pandémie |

Le greenwashing, ou l’art de verdir des chiffres alarmants

Les géants de la tech orchestrent une communication habile, mettant en avant leurs investissements massifs dans l’éolien ou le solaire pour dissimuler l’explosion de leur consommation globale d’énergie. Cette vitrine vertueuse masque une réalité bien plus sombre.

Ils jouent sur les subtilités des comptabilités carbone, privilégiant les calculs théoriques (Scope 2 market-based) à la réalité physique des réseaux, ce qui leur permet d’afficher un bilan artificiellement neutre.

Cette manœuvre s’apparente à du greenwashing caractérisé, conçu pour endormir la vigilance des citoyens et retarder toute régulation contraignante.

Vers une ia plus sobre ? les pistes pour un futur moins énergivore

Face à ce constat accablant, la question n’est plus de savoir si l’IA pollue, mais comment limiter la casse. Des voix s’élèvent pour appeler à un changement de cap radical.

La sobriété, le maître-mot de l’ademe

L’Ademe ne mâche pas ses mots face à la démesure actuelle. L’agence française insiste sur une nécessité absolue : développer une IA « avec sobriété » pour éviter le mur écologique qui se dresse devant nous.

Mais qu’est-ce que cela implique concrètement ? Il ne s’agit pas de tout arrêter, mais d’appliquer « le juste niveau de technologie ». Pourquoi utiliser un marteau-pilon énergétique quand une solution légère suffit à résoudre le problème posé ?

- Les piliers d’une IA sobre : Questionner la pertinence de l’usage de l’IA pour chaque cas.

- Favoriser des modèles plus petits et spécialisés (TinyML).

- Optimiser le code et les algorithmes pour réduire les calculs.

Un moratoire sur les data centers : la sonnette d’alarme des ong

La société civile refuse de rester spectatrice du désastre annoncé. Le 8 décembre dernier, une coalition de plus de 230 ONG a frappé fort aux États-Unis, exigeant une prise de conscience immédiate face à l’appétit insatiable du secteur.

Leur revendication est sans équivoque : l’instauration d’un moratoire sur la construction de nouveaux centres de données. Il faut geler les chantiers le temps de mesurer les dégâts réels sur les ressources locales.

Ce coup d’arrêt brutal sonne comme un ultime avertissement pour freiner une course technologique devenue incontrôlable.

Le double visage de l’ia : outil pour l’écologie ou fléau ?

Pourtant, jeter le bébé avec l’eau du bain serait une erreur stratégique. Si l’impact environnemental intelligence artificielle est indéniable, cette technologie demeure paradoxalement un outil au service de l’environnement capable de prouesses techniques.

On l’utilise déjà pour l’optimisation fine des réseaux électriques complexes, la surveillance satellitaire de la déforestation en temps réel ou la modélisation précise des scénarios du changement climatique.

Tout l’enjeu réside dans cet équilibre précaire. Il faut garantir que le gain écologique généré par l’algorithme ne soit pas englouti par le coût énergétique de son propre fonctionnement.

Repenser le modèle : vers des entreprises engagées

Au-delà de la technique, c’est la philosophie même du business model qui doit être revue. L’optimisation ne suffira pas si la finalité de l’entreprise reste la croissance aveugle des ressources consommées.

Les dirigeants doivent désormais intégrer cette variable critique et chercher activement à réduire votre impact environnemental, bien au-delà des simples effets d’annonce ou du greenwashing habituel.

Une voie prometteuse se dessine avec les entreprises à mission. Ces structures tentent de réconcilier la rentabilité économique avec un impact sociétal et écologique positif concret.

Alors que la course au gigantisme technologique s’accélère, l’empreinte matérielle de l’intelligence artificielle révèle une réalité insoutenable. Au-delà des promesses d’innovation, cette voracité énergétique et hydrique exige une remise en question profonde du modèle actuel, imposant la sobriété non plus comme une option, mais comme une condition de survie collective.